Geçtiğimiz birkaç ay boyunca yapay zeka topluluğu, Apple tarafından yayınlanan iki etkili araştırma makalesinin tetiklediği hararetli bir tartışmayla çalkalandı. İlki, dünyayı sarsan-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target=" _blank" id="">"GSM-Sembolik " (Ekim 2024) ve ikincisi, "Düşünme Yanılsaması" (Haziran 2025), Büyük Dil Modellerinin iddia edilen muhakeme yeteneklerini sorgulayarak sektörde karışık tepkilere yol açtı.

Daha önceki derinlemesine incelememizde ele aldığımız gibi "İlerleme İllüzyonu: Genel Yapay Zekayı Simüle Etmek, Ona Ulaşmadan", yapay akıl meselesi, makinelerde zeka olarak kabul ettiğimiz şeyin tam da özünü ilgilendirir.

Apple araştırmacıları, bir cevap vermeden önce ayrıntılı muhakeme izleri oluşturan modeller olan Büyük Muhakeme Modelleri (LRM) üzerinde sistematik bir analiz gerçekleştirdi. Sonuçlar şaşırtıcı ve birçokları için endişe vericiydi.

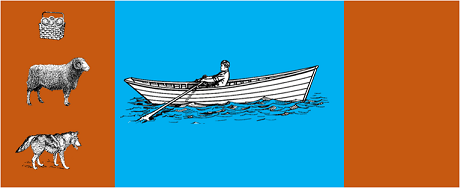

Çalışma, en gelişmiş modelleri aşağıdaki gibi klasik algoritmik bulmacalara tabi tutmuştur:

Sonuçlar, problem formülasyonundaki küçük değişikliklerin bile performansta önemli farklılıklara yol açtığını göstererek akıl yürütmede endişe verici bir kırılganlık olduğunu ortaya koymuştur. Rapor edildiği üzere AppleInsider kapsamı"GSM-Sembolik kıyaslama sorularındaki sadece sayısal değerler değiştirildiğinde tüm modellerin performansı düşmektedir".

Yapay zeka topluluğundan yanıtın gelmesi uzun sürmedi. Open Philanthropy'den Alex Lawsen, Anthropic'ten Claude Opus ile işbirliği içinde, aşağıdaki başlık altında ayrıntılı bir çürütme yayınladı "Düşünme Yanılsaması'.Apple çalışmasının metodolojilerine ve sonuçlarına itiraz ediyor.

Lawsen testleri alternatif metodolojilerle tekrarladığında - modellerden tüm hamleleri listelemek yerine özyinelemeli fonksiyonlar üretmelerini istediğinde - sonuçlar önemli ölçüde farklıydı. Claude, gemini ve GPT gibi modeller, Apple'ın sıfır başarı bildirdiği karmaşıklığın çok ötesinde, Hanoi Kulesi problemlerini 15 kayıtla doğru bir şekilde çözdü.

Gary MarcusLLM'lerin akıl yürütme becerilerini uzun süredir eleştiren Marcus, Apple'ın bulgularını 20 yıllık tezinin doğrulanması olarak kabul etti. Marcus'a göre, LLM'ler 'zaten çözülmüş problemlerin iyi çözücüleri' olarak kalırken, 'dağıtım kayması' - eğitim verilerinin ötesine genelleme yeteneği - ile mücadele etmeye devam ediyor.

Tartışma ayrıca aşağıdaki gibi uzmanlaşmış topluluklara da yayılmıştır Reddit'te LocalLlamageliştiricilerin ve araştırmacıların açık kaynak modelleri ve yerel uygulamalar için pratik sonuçları tartıştığı bir platformdur.

Bu tartışma sadece akademik bir tartışma değildir. Doğrudan etkileri vardır:

Birkaç makalede vurgulandığı gibi tekni̇k bi̇lgi̇lerbirleştiren hibrit yaklaşımlara giderek daha fazla ihtiyaç duyulmaktadır:

Önemsiz bir örnek: muhasebeye yardımcı olan bir yapay zeka asistanı. Dil modeli, "bu ay seyahat için ne kadar harcadım?" diye sorduğunuzu anlar ve ilgili parametreleri çıkarır (kategori: seyahat, dönem: bu ay). Ancak veritabanını sorgulayan, toplamı hesaplayan ve mali kısıtlamaları kontrol eden SQL sorgusu? Bu, nöral model tarafından değil, deterministik kod tarafından yapılır.

Apple makalesinin WWDC'den kısa bir süre önce yayınlanmış olması gözlemcilerin dikkatinden kaçmadı ve stratejik motivasyonlar hakkında soru işaretleri yarattı. Olarak9to5Mac tarafından analiz"Apple makalesinin zamanlaması - WWDC'den hemen önce - birkaç kaş kaldırdı. Bu bir araştırma dönüm noktası mıydı, yoksa Apple'ı daha geniş yapay zeka ortamında yeniden konumlandırmak için stratejik bir hamle miydi?"

Apple'ın makalelerinin tetiklediği tartışma, yapay zekayı anlamanın henüz erken aşamalarında olduğumuzu hatırlatıyor. Bizim de belirttiğimiz gibi önceki̇ makaleSimülasyon ve gerçek akıl yürütme arasındaki ayrım, zamanımızın en karmaşık zorluklarından biri olmaya devam etmektedir.

Asıl ders, LLM'lerin insani anlamda 'muhakeme' yapıp yapamayacağı değil, sınırlamalarını telafi ederken güçlü yönlerinden yararlanan sistemleri nasıl oluşturabileceğimizdir. Yapay zekanın halihazırda tüm sektörleri dönüştürdüğü bir dünyada, soru artık bu araçların 'akıllı' olup olmadığı değil, onları nasıl etkili ve sorumlu bir şekilde kullanacağımızdır.

Kurumsal yapay zekanın geleceği muhtemelen tek bir devrimci yaklaşımda değil, birbirini tamamlayan çeşitli teknolojilerin akıllıca düzenlenmesinde yatacaktır. Ve bu senaryoda, araçlarımızın yeteneklerini eleştirel ve dürüst bir şekilde değerlendirme becerisi, başlı başına bir rekabet avantajı haline geliyor.

Son Gelişmeler (Ocak 2026)

OpenAI, o3 ve o4-mini'yi piyasaya sürdü: 16 Nisan 2025'te OpenAI, o serisinin en gelişmiş akıl yürütme modelleri olan o3 ve o4-mini'yi piyasaya sürdü. Bu modeller artık web araması, dosya analizi, görsel akıl yürütme ve görüntü oluşturmayı birleştirerek araçları aktif bir şekilde kullanabilir. o3, Codeforces, SWE-bench ve MMMU gibi benchmarklarda yeni rekorlar kırarken, o4-mini yüksek hacimli akıl yürütme görevleri için performans ve maliyetleri optimize ediyor. Modeller, içeriği daha derinlemesine analiz için görsel olarak dönüştürerek "görüntülerle düşünme" yeteneğini sergiliyor.

DeepSeek-R1, yapay zeka sektörünü sarsıyor: Ocak 2025'te DeepSeek, OpenAI o1 ile karşılaştırılabilir performansa ulaşan ve eğitim maliyeti sadece 6 milyon dolar olan (batılı modellerin yüz milyonlarca dolarlık maliyetine karşılık) açık kaynaklı bir akıl yürütme modeli olan R1'i piyasaya sürdü. DeepSeek-R1, akıl yürütme yeteneklerinin, insan tarafından notlanmış kanıtlara ihtiyaç duymadan, saf pekiştirme öğrenimi yoluyla teşvik edilebileceğini kanıtladı. Model, onlarca ülkede App Store ve Google Play'de 1 numaralı ücretsiz uygulama oldu. Ocak 2026'da DeepSeek, eğitimin sırlarını ortaya koyan ve Monte Carlo Tree Search (MCTS) gibi tekniklerin genel akıl yürütme için işe yaramadığını açıkça itiraf eden 60 sayfalık genişletilmiş bir makale yayınladı.

Anthropic, Claude'un "Anayasasını" güncelliyor: 22 Ocak 2026'da Anthropic, Claude için 23.000 kelimelik yeni bir anayasa yayınladı ve kurallara dayalı bir yaklaşımdan etik ilkelerin anlaşılmasına dayalı bir yaklaşıma geçti. Bu belge, büyük bir AI şirketinin AI'nın bilinç veya ahlaki statüsünü resmi olarak tanıyan ilk çerçevesi oldu ve Anthropic'in Claude'un "psikolojik iyilik hali, benlik algısı ve refahı" ile ilgilendiğini belirtti.

Tartışma yoğunlaşıyor: Temmuz 2025'te yapılan bir çalışma, Apple'ın karşılaştırma ölçütlerini tekrarladı ve geliştirdi, LRM'lerin karmaşıklık orta derecede arttığında (Hanoi Kulesi'nde yaklaşık 8 disk) hala bilişsel sınırlamalar gösterdiğini doğruladı. Araştırmacılar, bunun sadece çıktı kısıtlamalarından değil, aynı zamanda gerçek bilişsel sınırlamalardan da kaynaklandığını kanıtlayarak, tartışmanın henüz sona ermediğini vurguladılar.

Kuruluşunuzun yapay zeka stratejisi ve sağlam çözümlerin uygulanmasına ilişkin içgörüler için uzman ekibimiz özelleştirilmiş danışmanlıklar için hazırdır.